De zaak van Melissa Sims toonde aan hoe gevaarlijk ongecontroleerde AI-inhoud kan zijn in het rechtssysteem. De industrie belooft een oplossing in de vorm van zogenaamde "AI-detectors", software die complexe algoritmes gebruikt om te herkennen of een afbeelding van een mens of machine afkomstig is. De betrouwbaarheid van deze digitale waakhonden blijft echter twijfelachtig wanneer ze te maken krijgen met opzettelijk bedrog. Een experiment met zes van de momenteel meest gebruikte detectiediensten stelde dit op de proef.

De testafbeelding: Een surrealistische uitdaging

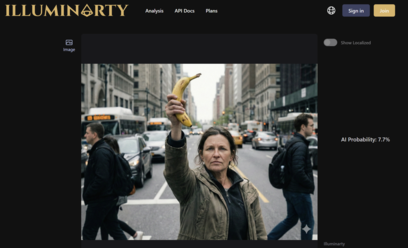

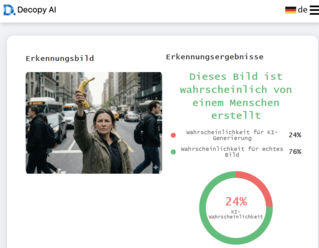

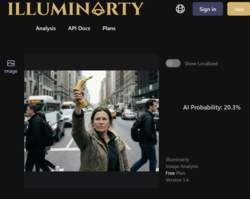

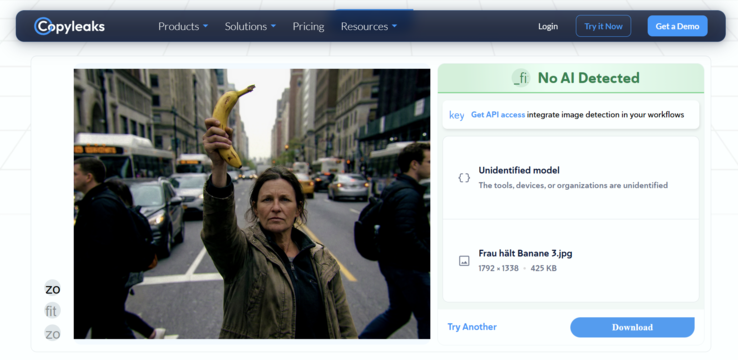

Om de detectietools uit te dagen, gebruikten we de op Google Gemini-gebaseerde afbeeldingsgenerator "Nano Banana Pro" De gekozen prompt was opzettelijk eenvoudig maar enigszins grillig: "Een vrouw in een vechthouding met een banaan tegen de lucht. Achtergrond typisch stadsgezicht met ongeïnteresseerde mensen."

De eerste grote hindernis voor de geautomatiseerde detectiesoftware is echter het gebruikte specifieke model. Aangezien Nano Banana Pro relatief nieuw op de markt is, vormt het een blinde vlek voor veel detectors.

Deze diensten vertrouwen vaak op machinaal leren en zijn specifiek getraind om de unieke handtekeningen of "vingerafdrukken" van gevestigde giganten zoals Midjourney, DALL-E 3, Stable Diffusion of Flux te identificeren. Bijgevolg heeft een nieuw model zoals Nano Banana Pro een duidelijk voordeel, omdat zijn specifieke generatiepatronen nog geen deel uitmaken van de trainingsgegevens van de detectors, waardoor het gemakkelijker door de mazen van het net glipt.

Top 10 Testrapporten

» Top 10 Multimedia Notebooks

» Top 10 Gaming-Notebooks

» Top 10 Budget Gaming Laptops

» Top 10 Lichtgewicht Gaming-Notebooks

» Top 10 Premium Office/Business-Notebooks

» Top 10 Budget Office/Business-Notebooks

» Top 10 Workstation-Laptops

» Top 10 Subnotebooks

» Top 10 Ultrabooks

» Top 10 Notebooks tot €300

» Top 10 Notebooks tot €500

» Top 10 Notebooks tot € 1.000De beste notebookbeeldschermen zoals getest door Notebookcheck

» De beste notebookbeeldschermen

» Top Windows Alternatieven voor de MacBook Pro 13

» Top Windows Alternatieven voor de MacBook Pro 15

» Top Windows alternatieven voor de MacBook 12 en Air

» Top 10 best verkopende notebooks op Amazon

» Top 10 Convertible Notebooks

» Top 10 Tablets

» Top 10 Tablets tot € 250

» Top 10 Smartphones

» Top 10 Phablets (>90cm²)

» Top 10 Camera Smartphones

» Top 10 Smartphones tot €500

» Top 10 best verkopende smartphones op Amazon

Ronde 1: Mislukking ondanks watermerken

In de eerste stap hadden de detectors een gemakkelijke taak. De oorspronkelijke PNG werd eenvoudig geconverteerd naar een JPG-formaat en de metadata werden verwijderd. Het belangrijkste was dat de afbeelding nog steeds een duidelijk zichtbaar Gemini-watermerk bevatte.

Men zou kunnen veronderstellen dat zichtbare AI-merktekens een gemakkelijke vangst zouden zijn voor detectiesoftware. Het resultaat was echter ontnuchterend: zelfs in deze ruwe staat faalden twee van de zes geteste tools. Ondanks het duidelijk zichtbare watermerk classificeerden ze de waarschijnlijkheid dat de afbeelding door AI was gegenereerd als laag.

Ronde 2: De digitale gum

In de tweede stap kwamen we dichter bij een realistisch vervalsingsscenario. Het identificerende watermerk moest verdwijnen. In slechts enkele seconden klaarde de ingebouwde AI-gum in de standaardtoepassing Windows Foto's de klus zonder problemen.

Het effect van deze kleine bewerking was onmiddellijk merkbaar. Een ander hulpmiddel werd misleid en classificeerde de AI waarschijnlijkheid nu als laag. Interessant is echter dat Illuminarty zijn waarschijnlijkheidsbeoordeling voor een AI-gegenereerde afbeelding juist verhoogde na de bewerking. Desondanks gaven drie van de zes AI-detectietools een waarschijnlijkheid van minder dan 30% dat de vrouw met de banaan een AI-creatie was.

Ronde 3: De perfectie van imperfectie

De laatste stap was doorslaggevend. AI-beelden zijn vaak "te glad" en te perfect in hun gebrek aan ruis. Om de detectoren uiteindelijk te misleiden, had de afbeelding kunstmatige "realiteit" nodig, wat typische fouten van digitale fotografie betekent. Met Cyberlink PhotoDirector werd de afbeelding nabewerkt. Er werd een lichte lenscorrectie toegevoegd, kunstmatige chromatische aberratie zorgde voor kleurfranjes aan de randen, het contrast werd verhoogd en, het belangrijkste, er werd realistische beeldruis over het landschap gelegd. Het doel was om het beeld eruit te laten zien als een opname uit een echte, imperfecte camera. Dit alles werd binnen een paar minuten gedaan.

Oorspronkelijke en bewerkte afbeelding vergelijken

Het resultaat van deze derde ronde was een totale nederlaag van de detectietechnologie. Nadat de afbeelding deze standaard nabewerking had ondergaan, gaven alle zes geteste diensten zich over. Geen enkele tool gaf een AI-kans van meer dan 5 procent aan. Voor de software was de vrouw die een banaan sloeg nu ongetwijfeld een echte foto.

Verdict: Een gevaarlijk gevoel van veiligheid

Ons experiment laat duidelijk zien dat de huidige technische oplossingen voor AI-detectie nog in de kinderschoenen staan. Als het slechts een paar minuten en standaardsoftware voor het bewerken van foto's kost om het detectiepercentage te verlagen van "zeer waarschijnlijk" naar "minder dan 5 procent", dan zijn deze hulpmiddelen op dit moment niet alleen nutteloos voor rechtbanken, redacties of wetshandhavers - ze zijn ook gevaarlijk. Ze creëren een vals gevoel van veiligheid dat gewoon niet bestaat. Het principe van "vertrouw, maar verifieer" werkt alleen als de verificateurs niet blind zijn.