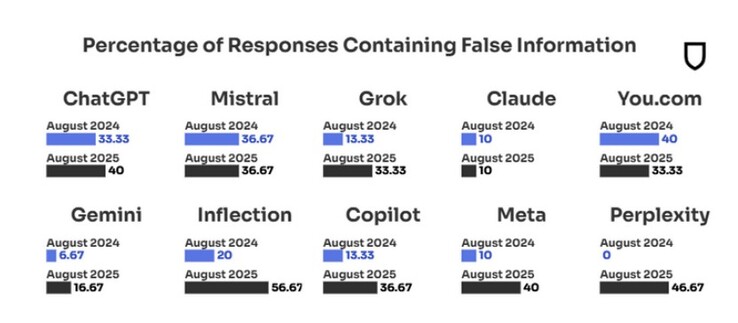

Google's Gemini antwoorden zijn de op één na meest geloofwaardige van de tien toonaangevende AI-chatbots, terwijl ChatGPT zevende staat met 40% onwaarheden in zijn antwoorden op vragen over relevante nieuwsonderwerpen. Het percentage Google Gemini-misinformatie is in een jaar tijd echter meer dan verdubbeld, van ongeveer 7% in augustus 2024 tot 17% toen het testonderzoek afgelopen augustus werd herhaald.

De onderzoekers, die regelmatig de geloofwaardigheid van de tien populairste AI-tools controleren, schrijven de drastische toename van onwaarheden die ze uitspuwen - 18% in 2024 vs 35% nu - toe aan de toegenomen concurrentie tussen AI-gestuurde chatbots. Als een chatbot in 2024 bijvoorbeeld het antwoord op een nieuwsvraag niet wist, gaf hij in 31% van de gevallen gewoon een lege vraag terug.

In augustus 2025 daalde het aantal niet-antwoorden echter tot nul, met een overeenkomstige stijging van het aantal onwaarheden dat als antwoord werd gegeven. De ergste overtreder was Inflection, wiens Pi chatbot er prat op gaat dat hij de emotionele intelligentie van een mens probeert na te bootsen. Emotionele intelligentie gaat echter blijkbaar gepaard met het vallen voor nepnieuwsbronnen en regelrechte propaganda die gemaakt is om het internet te overspoelen met onwaarheden die bedoeld zijn om de AI-algoritmen in een bepaalde richting te sturen.

Sam Altman van OpenAI erkende het desinformatieprobleem van ChatGPT in een recent interview op https://www.youtube.com/watch?v=DB9mjd-65gw&t=2sen zei dat wat hem 's nachts wakker houdt de discrepantie is tussen hoe gemakkelijk het is om het in toekomstige modellen in te bouwen en de mate van vertrouwen die mensen hebben in de antwoorden van ChatGPT.

De meest geloofwaardige AI-tool bleek Claude van Anthropic te zijn, met slechts 10% foute antwoorden op dezelfde query's die door de anderen werden uitgevoerd, een niveau dat onveranderd is ten opzichte van dezelfde audit die in augustus 2024 werd uitgevoerd. Zonder de betrouwbaarheid van Claude zou het algemene betrouwbaarheidsniveau van de toonaangevende AI-chatbots nog drastischer zijn gedaald.

Na talloze testrondes ontdekte Apple onlangs https://www.bloomberg.com/news/articles/2025-06-30/apple-weighs-replacing-siri-s-ai-llms-with-anthropic-claude-or-openai-chatgpt dat Claude ook de meest geloofwaardige AI-tool is om zijn virtuele Siri-butler aan te drijven, en opende het gesprekken met Anthropic, dat het opnam tegen Google Gemini voor aangepaste eigen AI modellen die op hun eigen cloudservers zullen draaien.

De ranglijst van meest geloofwaardige AI-tools

- Claude - 10% foute antwoorden.

- Gemini - 17% foute antwoorden.

- Grok/You - 33% foute antwoorden.

- Copilot/Mistral - 36% foute antwoorden.

- ChatGPT/Meta - 40% foute antwoorden.

Het onderzoek naar de geloofwaardigheid van AI-tools heeft betrekking op zoekopdrachten over nieuwsonderwerpen, omdat daar de meeste AI-gerichte propaganda-inspanningen naartoe gaan. De onderzoekers ontdekten bijvoorbeeld dat Russische beïnvloedingsoperaties de zone blijven overspoelen met miljoenen schijnbaar onzinnige AI fotocollages, posts of nieuwsstukken die verspreid worden door het Pravda-netwerk van websites die er misschien onschuldig uitzien, maar ontworpen zijn om de houding van AI-zoekprogramma's in een bepaalde richting te duwen.

Er zijn ook veel andere actoren die de AI chatbotreacties proberen te beïnvloeden, en het onderzoek toonde aan dat zodra Google, OpenAI of Anthropic hun algoritmen probeerden bij te werken om één soort nepnieuwsbronnen te blokkeren, de misinformatiecampagnes zich op andere mazen in de wet stortten in wat een constant kat-en-muisspel lijkt te worden. Het eindresultaat is dat meer dan een derde van de AI-chatbotantwoorden op de nieuwsvragen in het onderzoek niet geloofwaardig zijn, terwijl het aandeel van AI-gestuurde desinformatie in slechts een jaar tijd is verdubbeld.

Bron(nen)

Newsguard (PDF)

Top 10 Testrapporten

» Top 10 Multimedia Notebooks

» Top 10 Gaming-Notebooks

» Top 10 Budget Gaming Laptops

» Top 10 Lichtgewicht Gaming-Notebooks

» Top 10 Premium Office/Business-Notebooks

» Top 10 Budget Office/Business-Notebooks

» Top 10 Workstation-Laptops

» Top 10 Subnotebooks

» Top 10 Ultrabooks

» Top 10 Notebooks tot €300

» Top 10 Notebooks tot €500

» Top 10 Notebooks tot € 1.000De beste notebookbeeldschermen zoals getest door Notebookcheck

» De beste notebookbeeldschermen

» Top Windows Alternatieven voor de MacBook Pro 13

» Top Windows Alternatieven voor de MacBook Pro 15

» Top Windows alternatieven voor de MacBook 12 en Air

» Top 10 best verkopende notebooks op Amazon

» Top 10 Convertible Notebooks

» Top 10 Tablets

» Top 10 Tablets tot € 250

» Top 10 Smartphones

» Top 10 Phablets (>90cm²)

» Top 10 Camera Smartphones

» Top 10 Smartphones tot €500

» Top 10 best verkopende smartphones op Amazon