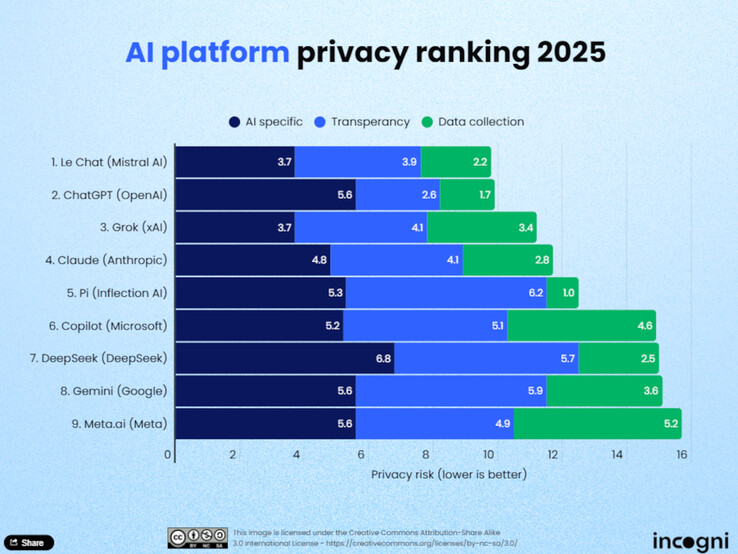

Het gebruik van kunstmatige intelligentie (AI) in het dagelijks leven neemt toe, en daarmee ook het belang van gegevensbescherming. Analisten op het gebied van gegevensbescherming van Incogni hebben onlangs negen toonaangevende Large Language Models (LLM's) geëvalueerd om te bepalen welke platforms de privacy van gebruikers het meest respecteren. Het onderzoek evalueert de AI-modellen op basis van elf criteria, verdeeld in drie hoofdcategorieën: gegevensverzameling voor training, transparantie en gegevensgebruik en -deling.

Top klasseringen

Le Chat van Mistral AI voert de ranglijst aan. Volgens Incogni verzamelt het model relatief weinig gebruikersgegevens en biedt het een zeer data-efficiënte aanpak, zowel tijdens de trainingsfase als tijdens live gebruik. Op de voet gevolgd door ChatGPT van OpenAI, dat vooral punten scoort voor zijn transparantie. Gebruikers kunnen in hun account specifiek aangeven of hun chats gebruikt mogen worden om het model verder te ontwikkelen, en als de geschiedenis gedeactiveerd is, wordt opslag voorkomen. Grok van xAI neemt de derde plaats in en maakt ook indruk met zijn transparante gegevensbeschermingspraktijken.

Laatste in de ranglijst

Onderaan de ranglijst staan Meta AI, Gemini van Google en Copilot van Microsoft. Volgens Incogni verzamelen deze platforms uitgebreide gegevens zonder gebruikers duidelijke opt-out opties te bieden. DeepSeek, een Chinees model, presteert ook slecht. Deze aanbieders bieden geen duidelijke opties om gebruikersgegevens uit te sluiten van training.

Methodologie

De analisten van Incogni evalueerden de platforms op basis van elf criteria, verdeeld in drie categorieën: gegevensverzameling voor training, transparantie en gegevensgebruik en -deling. De categorie "gebruik en delen van gegevens" was goed voor 50% van de totale beoordeling, terwijl "transparantie" goed was voor 30% en "trainingsgegevens" voor 20%. Slechts vier van de negen geteste tools bieden gebruikers de mogelijkheid om hun gegevens actief uit te sluiten van training.

Conclusie

Het onderzoek toont aan dat gegevensbescherming nog niet overal standaard is in de wereld van AI. Gebruikers moeten zich daarom actief verdiepen in het privacybeleid van de aanbieders, vooral als het gaat om gevoelige inhoud, vertrouwelijke klantgegevens of persoonlijke gegevens. Degenen die waarde hechten aan gegevensbescherming zullen redelijke opties vinden in Le Chat, ChatGPT of Grok. Echt gegevensefficiënte LLM's zullen in 2025 echter nog steeds een uitzondering zijn

Bron(nen)

Top 10 Testrapporten

» Top 10 Multimedia Notebooks

» Top 10 Gaming-Notebooks

» Top 10 Budget Gaming Laptops

» Top 10 Lichtgewicht Gaming-Notebooks

» Top 10 Premium Office/Business-Notebooks

» Top 10 Budget Office/Business-Notebooks

» Top 10 Workstation-Laptops

» Top 10 Subnotebooks

» Top 10 Ultrabooks

» Top 10 Notebooks tot €300

» Top 10 Notebooks tot €500

» Top 10 Notebooks tot € 1.000De beste notebookbeeldschermen zoals getest door Notebookcheck

» De beste notebookbeeldschermen

» Top Windows Alternatieven voor de MacBook Pro 13

» Top Windows Alternatieven voor de MacBook Pro 15

» Top Windows alternatieven voor de MacBook 12 en Air

» Top 10 best verkopende notebooks op Amazon

» Top 10 Convertible Notebooks

» Top 10 Tablets

» Top 10 Tablets tot € 250

» Top 10 Smartphones

» Top 10 Phablets (>90cm²)

» Top 10 Camera Smartphones

» Top 10 Smartphones tot €500

» Top 10 best verkopende smartphones op Amazon