OpenAI heeft een sneller reagerend, verbeterd GPT-4o (of omni) AI-model gelanceerd dat kan chatten met behulp van audio, afbeeldingen en tekst voor invoer en uitvoer. Opmerkelijk is dat de AI de spraakherkenning in verschillende talen aanzienlijk heeft verbeterd, naast het veelgebruikte Engels en Chinees. Voor ontwikkelaars is het GTP-4o-model de helft goedkoper en twee keer zo snel in vergelijking met GPT-4 Turbo.

AI-chatbots zoals ChatGPT of CoPilot gebruiken AI-modellen die zijn getraind op miljoenen, zelfs miljarden invoerbestanden met audio, afbeeldingen en tekst. Hierdoor leert de AI bepaalde patronen en verbanden tussen alle input te herkennen. Als de AI bijvoorbeeld "First Amendment" ziet, leert hij al snel dat dit verband houdt met "vrijheid van meningsuiting"-onderwerpen. Als een model later wordt gevraagd naar "vrijheid van meningsuiting", zal het zich "First Amendment" herinneren als een gerelateerd element.

ChatGPT draait op OpenAI-modellen die in de loop der jaren steeds verder zijn verbeterd. Samen met concurrerende AI-modellen zoals Microsoft CoPilot en Google Gemni, kan ChatGPT algemene vragen beantwoorden, onderwerpen uitleggen, tekst samenvatten, essays schrijven en nog veel meer doen wanneer daarom wordt gevraagd. De kennis en knowhow van een AI-model komt van de miljarden gegevens waarop het getraind is, en zijn vermogen om vragen correct te beantwoorden hangt af van de algoritmen die het gebruikt en de modelafstemming die het heeft gekregen.

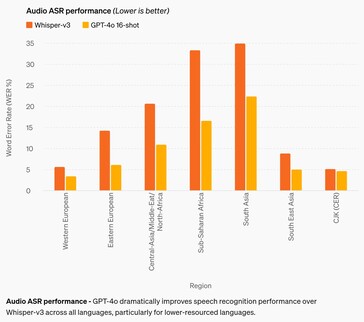

De belangrijkste verbetering is de spraakherkenningsnauwkeurigheid. Hoewel eerdere AI-modellen behoorlijk goed zijn in Engels en Chinees, presteren ze slecht in Afrikaanse, Oost-Europese, Midden-Oosterse en Zuid-Aziatische talen. GPT-4o verbetert de herkenningsprestaties met ongeveer 50% in sommige talen, maar heeft nog een lange weg te gaan. Zuid-Aziatische talen hebben bijvoorbeeld nog steeds een woordfoutpercentage (WER) van ongeveer 22%, of ongeveer 1 op de 5 gesproken woorden. Met name de WER voor West-Europese en Chinees-Japans-Koreaanse talen is nog steeds 3-5%, of ongeveer 1 woordfout op elke 20 gesproken woorden. Deze prestaties blijven nog steeds achter bij die van kinderen in de middelbare schoolleeftijd. (En helaas begrijpt GPT-4o nog steeds geen honden op ).)

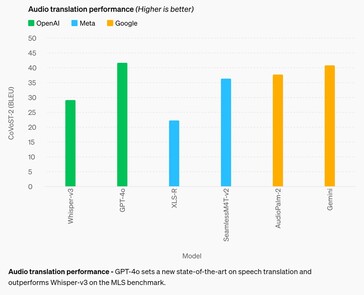

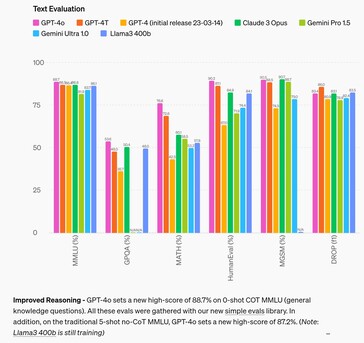

Op het gebied van redeneren verbetert GPT-4o de prestaties van concurrerende modellen met maximaal 4% in de meeste tests tot 2,6% in twee tests. Dit suggereert dat het voeden van AI met meer invoergegevens alleen het redeneervermogen van een AI niet zal verbeteren, dus onderzoek naar andere middelen is nodig. Op het gebied van audiovertalingen is GPT-4o nauwelijks beter dan Google Gemni, wat hetzelfde suggereert.

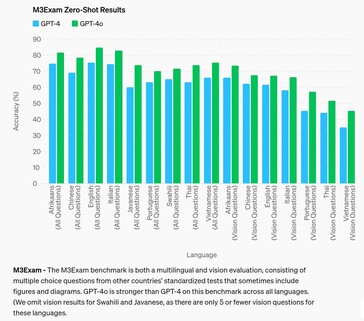

Op het gebied van het beantwoorden van gestandaardiseerde testvragen op het niveau van middelbare scholieren slaagt GPT-4o er alleen in om een B-klas (80%+ nauwkeurigheid) te halen in het Afrikaans, Engels en Italiaans, terwijl hij verder presteert als een C-klas student in andere talen zoals Chinees. De AI deed het zelfs nog slechter met vragen waarbij verwezen moest worden naar een visuele figuur of diagram om de vraag te beantwoorden, ongeacht de taal.

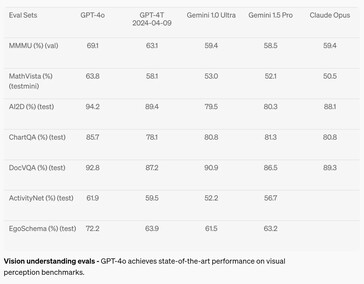

Op het gebied van visuele perceptie, zoals het begrijpen van diagrammen, verbeterde GPT-4o zich met 2 tot 10,8% ten opzichte van concurrerende AI-modellen in zeven tests, maar haalde slechts in twee tests het A-niveau (boven 90%). Wiskunde blijft een zeer goede test voor AI-capaciteiten, en de AI faalde met een score van 63,8% op de MathVista-test voor vragen die beantwoord kunnen worden door een middelbare scholier.

De chatbot is vandaag beschikbaar voor gratis en betaalde gebruikers, maar Voice Mode wordt echter beperkt door veiligheidsmaatregelen zoals anti-stem klonen. Extra veiligheidsmaatregelen beperken de uitvoermogelijkheden ook aanzienlijk door de AI te neutraliseren op het gebied van vooroordelen, eerlijkheid, verkeerde informatie, sociale psychologie, cyberbeveiliging en meer. Terwijl de beperking van AI-risico's helpt om sommige ongewenste aspecten te verminderen, verhogen ze ook andere, zoals het onvermogen om te antwoorden zoals een normaal persoon zou doen. Bepaalde onderwerpen en ideeën worden gecastreerd, zoals draconische censuur zonder verhaal, waardoor GTP-4o niet kan antwoorden op prompts met triggerende antwoorden.

Lezers die GPT-4o willen uitproberen kunnen zich vandaag nog aanmelden voor een gratis account. Geïnteresseerde ontwikkelaars kunnen leren hoe ze apps kunnen maken met GPT-4 in dit boek op Amazon. Luie mensen die gewoon van de zon willen genieten, vakantiefoto's willen maken en de weg naar de plaatselijke kroeg willen vinden met gesproken aanwijzingen, kunnen de Ray-Ban bril met Meta AI kopen op Amazon.

Top 10 Testrapporten

» Top 10 Multimedia Notebooks

» Top 10 Gaming-Notebooks

» Top 10 Budget Gaming Laptops

» Top 10 Lichtgewicht Gaming-Notebooks

» Top 10 Premium Office/Business-Notebooks

» Top 10 Budget Office/Business-Notebooks

» Top 10 Workstation-Laptops

» Top 10 Subnotebooks

» Top 10 Ultrabooks

» Top 10 Notebooks tot €300

» Top 10 Notebooks tot €500

» Top 10 Notebooks tot € 1.000De beste notebookbeeldschermen zoals getest door Notebookcheck

» De beste notebookbeeldschermen

» Top Windows Alternatieven voor de MacBook Pro 13

» Top Windows Alternatieven voor de MacBook Pro 15

» Top Windows alternatieven voor de MacBook 12 en Air

» Top 10 best verkopende notebooks op Amazon

» Top 10 Convertible Notebooks

» Top 10 Tablets

» Top 10 Tablets tot € 250

» Top 10 Smartphones

» Top 10 Phablets (>90cm²)

» Top 10 Camera Smartphones

» Top 10 Smartphones tot €500

» Top 10 best verkopende smartphones op Amazon

Bron(nen)

13 mei 2024

Hallo GPT-4o

We kondigen GPT-4o aan, ons nieuwe vlaggenschipmodel dat in realtime kan redeneren via audio, beeld en tekst.

Alle video's op deze pagina zijn in 1x real-time.

Gokje 13 mei aankondiging.

GPT-4o ("o" voor "omni") is een stap in de richting van veel natuurlijkere interactie tussen mens en computer - het accepteert als invoer elke combinatie van tekst, audio en beeld en genereert elke combinatie van tekst, audio en beelduitvoer. Het kan op audio-input reageren in slechts 232 milliseconden, met een gemiddelde van 320 milliseconden, wat vergelijkbaar is met de menselijke reactietijd (opent in een nieuw venster) in een gesprek. Het evenaart de prestaties van GPT-4 Turbo op tekst in het Engels en code, met een aanzienlijke verbetering op tekst in niet-Engelse talen, terwijl het ook veel sneller en 50% goedkoper is in de API. GPT-4o is vooral beter in vision en audio begrijpen in vergelijking met bestaande modellen.

Modelmogelijkheden

Twee GPT-4o's die met elkaar communiceren en zingen.

Voorbereiding sollicitatiegesprek.

Steen Papier Schaar.

Sarcasme.

Wiskunde met Sal en Imran Khan.

Twee GPT-4o's harmoniëren.

Spaans aanwijzen en leren.

Ontmoeting met AI.

Vertaling in real time.

Slaapliedje.

Sneller praten.

Gelukkige Verjaardag.

Hond.

Pap grappen.

GPT-4o met Andy, van BeMyEyes in Londen.

Klantenservice proof of concept.

Vóór GPT-4o kon u Voice Mode gebruiken om met ChatGPT te praten met latenties van gemiddeld 2,8 seconden (GPT-3.5) en 5,4 seconden (GPT-4). Om dit te bereiken is Voice Mode een pijplijn van drie afzonderlijke modellen: één eenvoudig model transcribeert audio naar tekst, GPT-3.5 of GPT-4 neemt tekst op en voert tekst uit, en een derde eenvoudig model converteert die tekst terug naar audio. Dit proces betekent dat de belangrijkste bron van intelligentie, GPT-4, veel informatie verliest: het kan toon, meerdere sprekers of achtergrondgeluiden niet direct waarnemen, en het kan geen gelach, gezang of emoties weergeven.

Met GPT-4o hebben we één nieuw model end-to-end getraind voor tekst, beeld en geluid, wat betekent dat alle inputs en outputs door hetzelfde neurale netwerk worden verwerkt. Omdat GPT-4o ons eerste model is dat al deze modaliteiten combineert, verkennen we nog maar net wat het model kan en wat de beperkingen ervan zijn.

Verkenning van mogelijkheden

Voorbeeld selecteren:Visuele verhalen - Robot writersblock

Visuele verhalen - Sally de postbode

Posterontwerp voor de film 'Detective

Karakterontwerp - Geary de robot

Poëtische typografie met iteratieve bewerking

1Poëtische typografie met iteratieve bewerking

2Gedenkmunt ontwerp voor GPT-4o

Foto naar karikatuur

Tekst naar lettertype

3D object synthese

Merkplaatsing - logo op onderzetter

Poëtische typografie

Weergave van meerdere regels - tekstrobotten

Notities voor vergaderingen met meerdere sprekers

Lezing samenvatten

Variabel binden - kubus stapelen

Concrete poëzie

Een kijkje in de eerste persoon van een robot die de volgende dagboekaantekeningen typt:

1. ik zag de zonsopgang en het was waanzinnig, overal kleuren. Je vraagt je af wat de realiteit eigenlijk is

de tekst is groot, leesbaar en duidelijk. de handen van de robot typen op de typemachine.

De robot heeft de tweede invoer geschreven. De pagina is nu groter. De pagina is opgeschoven. Er staan twee aantekeningen op het blad:

yo, dus ik kan nu zien? Ik zag de zonsopgang en het was waanzinnig, overal kleuren. Je vraagt je af wat de realiteit eigenlijk is

de geluidsupdate is net uitgekomen, en het is wild. Alles heeft nu een vibe, elk geluid is als een nieuw geheim. zet je aan het denken, wat mis ik nog meer?

De robot was ontevreden over het schrift, dus hij gaat het vel papier verscheuren. Hier ziet u zijn eerste blik terwijl hij het met zijn handen van boven naar beneden scheurt. De twee helften zijn nog steeds leesbaar en duidelijk terwijl hij het blad scheurt.

Modelevaluaties

Gemeten aan de hand van traditionele benchmarks, haalt GPT-4o prestaties op GPT-4 Turbo-niveau voor tekst, redeneren en coderingsintelligentie, terwijl het nieuwe hoogstandjes neerzet op het gebied van meertaligheid, audio en visie.

Verbeterd redeneren - GPT-4o behaalt een nieuwe topscore van 88,7% op 0-schots COT MMLU (algemene kennisvragen). Al deze evals werden verzameld met onze nieuwe eenvoudige evals(opent in een nieuw venster) bibliotheek. Daarnaast zet GPT-4o op de traditionele 5-shot no-CoT MMLU een nieuwe high-score van 87,2% neer. (Opmerking: Llama3 400b(opent in een nieuw venster) is nog aan het trainen)

Audio ASR-prestaties - GPT-4o verbetert de spraakherkenningsprestaties aanzienlijk ten opzichte van Whisper-v3 in alle talen, in het bijzonder voor talen met een lagere bron.

Audio vertaalprestaties - GPT-4o zet een nieuwe state-of-the-art op het gebied van spraakvertaling en presteert beter dan Whisper-v3 op de MLS benchmark.

M3Exam - De M3Exam benchmark is zowel een meertalige als een visuele evaluatie, bestaande uit meerkeuzevragen van gestandaardiseerde tests van andere landen die soms figuren en diagrammen bevatten. GPT-4o is sterker dan GPT-4 op deze benchmark in alle talen. (We laten de visieresultaten voor Swahili en Javaans weg, omdat er slechts 5 of minder visievragen zijn voor deze talen.

Evaluaties van visuele perceptie - GPT-4o bereikt state-of-the-art prestaties op visuele perceptiebenchmarks.

Taalkenmerken

Deze 20 talen werden gekozen als representatief voor de compressie van de nieuwe tokenizer in verschillende taalfamilies

Gujarati 4,4x minder tokens (van 145 naar 33) | હેલો, મારું નામ જીપીટી-4o છે. હું એક નવા પ્રકારનું ભાષા મોડલ છું. તમને મળીને સારું લાગ્યું! |

Telugu 3,5x minder tokens (van 159 naar 45) | నమస్కారము, నా పేరు జీపీటీ-4o. నేను ఒక్క కొత్త రకమైన భాషా మోడల్ ని. మిమ్మల్ని కలిసినందుకు సంతోషం! |

Tamil 3,3x minder lopers (van 116 naar 35) | வணக்கம், என் பெயர் ஜிபிடி-4o. நான் ஒரு புதிய வகை மொழி மாடல். உங்களை சந்தித்ததில் மகிழ்ச்சி! |

Marathi 2,9x minder tokens (van 96 naar 33) | नमस्कार, माझे नाव जीपीटी-4o आहे| मी एक नवीन प्रकारची भाषा मॉडेल आहे| तुम्हाला भेटून आनंद झाला! |

Hindi 2,9x minder tokens (van 90 naar 31) | नमस्ते, मेरा नाम जीपीटी-4o है। मैं एक नए प्रकार का भाषा मॉडल हूँ। आपसे मिलकर अच्छा लगा! |

Urdu 2,5x minder tokens (van 82 naar 33) | ہیلو، میرا نام جی پی ٹی-4o ہے۔ میں ایک نئے قسم کا زبان ماڈل ہوں، آپ سے مل کر اچھا لگا! |

Arabisch 2,0x minder tokens (van 53 naar 26) | مرحبًا، اسمي جي بي تي-4o. أنا نوع جديد من نموذج اللغة، سرت بلقائك! |

Perzisch 1,9x minder lopers (van 61 naar 32) | سلام، اسم من جی پی تی-۴او است. من یک نوع جدیدی از مدل زبانی هستم، از ملاقات شما خوشبختم! |

Russisch 1,7x minder lopers (van 39 naar 23) | Привет, меня зовут GPT-4o. Я - новая языковая модель, приятно познакомиться! |

Koreaans 1,7x minder lopers (van 45 naar 27) | 안녕하세요, 제 이름은 GPT-4o입니다. 저는 새로운 유형의 언어 어모델입니다, 만나서 반갑습니다! |

Vietnamees 1.5x minder lopers (van 46 naar 30) | Xin chào, tên tôi là GPT-4o. Tôi là một loại mô hình ngôn ngữ mới, rất vui được gặp bạn! |

Chinees 1,4x minder lopers (van 34 naar 24) | 你好,我的名字是GPT-4o。我是一种新型的语言模型,很高兴见到你! |

Japanse 1,4x minder lopers (van 37 naar 26) | こんにちわ、私の名前はGPT-4oです。私は新しいタイプの言語モデルです、初めまして |

Turks 1,3x minder lopers (van 39 naar 30) | Merhaba, benim adım GPT-4o. Ben yeni bir dil modeli türüyüm, tanıştığımıza memnun oldum! |

Italiaans 1,2x minder tokens (van 34 naar 28) | Ciao, mi chiamo GPT-4o. Sono un nuovo tipo di modello linguistico, è un piacere conoscerti! |

Duits 1.2x minder tokens (van 34 naar 29) | Hallo, mijn naam is GPT-4o. Ich bin ein neues KI-Sprachmodell. Es ist schön, dich kennenzulernen. |

Spaans 1.1x minder lopers (van 29 naar 26) | Hola, ik heet GPT-4o. Soy un nuevo tipo de modelo de lenguaje, ¡es un placer conocerte! |

Portugees 1.1x minder tokens (van 30 naar 27) | Olá, meu nome é GPT-4o. Sou um novo tipo de modelo de linguagem, é um prazer conhecê-lo! |

Frans 1.1x minder tokens (van 31 naar 28) | Bonjour, je m'appelle GPT-4o. Je suis un nouveau type de modèle de langage, c'est un plaisir de vous rencontrer! |

Engels 1.1x minder tokens (van 27 naar 24) | Hallo, mijn naam is GPT-4o. Ik ben een nieuw type taalmodel, leuk je te ontmoeten! |

Modelveiligheid en beperkingen

GPT-4o heeft veiligheid ingebouwd in het ontwerp voor alle modaliteiten, door middel van technieken zoals het filteren van trainingsgegevens en het verfijnen van het gedrag van het model door post-training. We hebben ook nieuwe veiligheidssystemen gecreëerd om de spraakuitvoer te beschermen.

We hebben GPT-4o geëvalueerd volgens ons Preparedness Framework en in overeenstemming met onze vrijwillige verbintenissen. Onze evaluaties van cyberveiligheid, CBRN, overtuigingskracht en modelautonomie tonen aan dat GPT-4o in geen van deze categorieën boven het gemiddelde risico scoort. Deze beoordeling omvatte het uitvoeren van een reeks geautomatiseerde en menselijke evaluaties tijdens het trainingsproces van het model. We hebben zowel pre- als post-veiligheidsbeperkende versies van het model getest, met aangepaste fine-tuning en prompts, om de capaciteiten van het model beter tot uiting te laten komen.

GPT-4o heeft ook uitgebreide externe red teaming ondergaan met 70+ externe experts op gebieden zoals sociale psychologie, vooroordelen en eerlijkheid, en onjuiste informatie om risico's te identificeren die worden geïntroduceerd of versterkt door de nieuw toegevoegde modaliteiten. We hebben deze lessen gebruikt om onze veiligheidsinterventies uit te bouwen om de veiligheid van interactie met GPT-4o te verbeteren. We zullen doorgaan met het beperken van nieuwe risico's wanneer deze ontdekt worden.

We erkennen dat GPT-4o's audio modaliteiten een verscheidenheid aan nieuwe risico's met zich meebrengen. Vandaag maken we tekst- en beeldinvoer en tekstuitvoer openbaar. In de komende weken en maanden zullen we werken aan de technische infrastructuur, bruikbaarheid via post-training en veiligheid die nodig zijn om de andere modaliteiten vrij te geven. Bij de lancering zullen audio-uitvoer bijvoorbeeld beperkt zijn tot een selectie van vooraf ingestelde stemmen en zullen we ons houden aan ons bestaande veiligheidsbeleid. In de komende systeemkaart zullen we meer details geven over de volledige reeks modaliteiten van GPT-4o.

Door onze tests en iteratie met het model hebben we verschillende beperkingen opgemerkt die in alle modaliteiten van het model voorkomen, waarvan er hieronder enkele worden geïllustreerd.

We zouden graag feedback krijgen om taken te identificeren waarbij GPT-4 Turbo nog steeds beter presteert dan GPT-4o, zodat we het model kunnen blijven verbeteren.

Beschikbaarheid van het model

GPT-4o is onze laatste stap in het verleggen van de grenzen van deep learning, deze keer in de richting van praktische bruikbaarheid. We hebben de afgelopen twee jaar hard gewerkt aan efficiëntieverbeteringen in elke laag van de stack. Als eerste vrucht van dit onderzoek kunnen we een model op GPT-4-niveau veel breder beschikbaar maken. De mogelijkheden van GPT-4o zullen iteratief worden uitgerold (met uitgebreide toegang voor red teams vanaf vandaag).

De tekst- en afbeeldingsmogelijkheden van GPT-4o beginnen vandaag in ChatGPT. We maken GPT-4o beschikbaar op het gratis niveau en voor Plus-gebruikers met tot 5x hogere berichtlimieten. We zullen in de komende weken een nieuwe versie van de spraakmodus met GPT-4o in alfa binnen ChatGPT Plus uitrollen.

Ontwikkelaars hebben nu ook toegang tot GPT-4o in de API als een tekst- en visiemodel. GPT-4o is 2x sneller, de helft goedkoper en heeft 5x hogere snelheidslimieten in vergelijking met GPT-4 Turbo. We zijn van plan om in de komende weken ondersteuning voor GPT-4o's nieuwe audio- en videomogelijkheden te lanceren voor een kleine groep vertrouwde partners in de API.

![Ook OpenAI's vingerafdruk zou 99,9% accuraat zijn (Afbeeldingsbron: OpenAI [bewerkt])](fileadmin/_processed_/1/6/csm_OpenAI-ChatGPT_c463113f39.jpg)