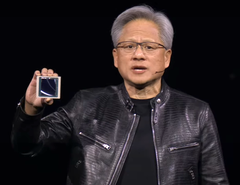

Nvidia CEO Jensen Huang heeft de nieuwste AI-producten en -diensten van het bedrijf onthuld tijdens de keynote op GTC 2024 op 18 maart 2024 in San Jose, CA. De nieuwe Nvidia-producten, die gericht zijn op zakelijke klanten, beloven het leren van AI en de toepassing ervan op vele gebieden, zoals robotica, weersvoorspelling, ontdekking van medicijnen en magazijnautomatisering, aanzienlijk te versnellen. De Nvidia Blackwell GPU, NIMs, NEMO en AI foundry behoorden tot de opmerkelijke onthullingen.

Het AI-trainingsproces is veel computerintensiever dan het gebruik van een AI-model omdat er miljoenen invoerdocumenten verwerkt moeten worden. Dit kan weken, zelfs maanden duren op de allersnelste supercomputers die tegenwoordig beschikbaar zijn voor bedrijven als Microsoft. Nvidia heeft eerder het Hopper GPU-platform uitgebracht in 2022 om dergelijke grote rekenlasten aan te kunnen.

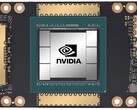

Tijdens GTC 2024 onthulde Huang Blackwell als de opvolger van Hopper en is beschikbaar als een drop-in bordvervanger voor huidige Hopper-installaties. De Blackwell GPU bestaat uit dubbele-104 miljard transistor GPU-matrijzen op een TSMC 4NP-proces (waarschijnlijk N4P, typefout in presentatie) voor 20 FP4 petaflops met 192 GB HBM3e geheugen dat 8TB/s kan overbrengen. Ter vergelijking, een desktop 4090 GPU heeft een enkele GPU met 76,3 miljard transistors, een 5NM-proces, tot 1,32 Tensor FP8 petaflops prestaties met 24 GB GDDR6X-geheugen. Als men het getal van 4090 FP8 verdubbelt om het aan te passen aan 4-bits, dan is dat ongeveer 20 petaflops Blackwell vs. 3 petaflops 4090.

Wanneer 72 Blackwell GPU's in een enkele DGX GB200 NVL72 kast in combinatie met vloeistofkoeling, verbeterde NVLink CPU'sen andere interconnectieverbeteringen, stijgen de prestaties ten opzichte van Hopper-kasten met 22x voor FP8 AI-training en 45x voor FP4 AI-inferentie. Het stroomverbruik van Blackwell AI-training is ook ongeveer 4x lager dan bij Hopper.

NIMS voorverpakte AI-modellen

Om te profiteren van deze sprong in prestaties, introduceerde Nvidia voorverpakte AI-modellen genaamd NIMS (Nvidia Inference Microservice)die Kubernetes gebruikt om lokaal of in de cloud op Nvidia CUDA GPU's te draaien. Toegang tot de stand-alone NIMS gebeurt via een vereenvoudigde HUMAN API. Het doel hierachter is om een toekomst te creëren waarin AI-diensten worden gecreëerd door een AI te vragen om een app met bepaalde functies te maken, waarna de AI verschillende NIMS met elkaar mengt en matcht zonder dat programmeren op laag niveau nodig is. Om te helpen bij het trainen van NIMS introduceerde Nvidia NeMO Microservices om het trainingsproces op bedrijfsdocumenten aan te passen, te evalueren en te bewaken.

Nvidia BioNeMO en biologisch NIMS

Huang kondigde aan dat Nvidia NIMS gaat ontwikkelen die getraind is op biologische en medische gegevens om onderzoekers gemakkelijker toegang te geven tot AI die alle aspecten van de geneeskunde kan verbeteren, zoals het sneller vinden van kandidaat-geneesmiddelen.

Thor ASIL-D en BYD autonome EV-voertuigen

Veelzeggend is dat Huang verklaarde dat BYD de allereerste EV-autofabrikant ter wereld zal zijn die hun nieuwe Thor ASIL-D computer zal gebruiken die een AI SoC gebruikt voor het verwerken van visuele en rij-input om een hoge veiligheid te bieden bij autonoom rijden. In combinatie met de recente aankondiging van van SuperDrive by Plussuggereert dit dat BYD een van de eerste autobedrijven zal zijn die een Level 4 autonoom EV-voertuig uitbrengt autonoom EV-voertuig uitbrengt.

Nvidia Project Groot humanoïde robots

Huang toonde verder hun vooruitgang in robotica door de vaardigheden van hun robots te laten zien, die eerst worden getraind in het Omniversum als een digitale tweeling en vervolgens taken mogen uitvoeren in levensechte robotlichamen. Er werd getoond hoe ze konden bakken, met hun vingers stokjes konden draaien, producten konden sorteren en in elkaar zetten en om obstakels heen konden navigeren. Om dit niveau van robotica te bereiken, werd de Nvidia Project Groot AI gecreëerd door deze eerst te trainen op tekst, video en demonstratie-input, en vervolgens verder te verfijnen met daadwerkelijke observaties van taken die werden uitgevoerd. Gekoppeld aan dezelfde Thor-computer die in voertuigen wordt gebruikt en Nvidia Tokkio AI taalmodel, konden demonstratierobots handelingen van mensen observeren en deze vervolgens nadoen om drankjes te maken, te drummen en te reageren op gesproken verzoeken.

Nvidia Omniverse Cloud voegt ondersteuning toe voor Apple Vision Pro

Van ondergeschikt belang verklaarde Huang dat de Nvidia Omniverse Cloud nu streamt naar de Apple Vision Pro headset naast de Meta Quest en HTC Vive Produidelijk voor ontwikkelaars die Nvidia cloud GPU's gebruiken, aangezien geen enkele Macintosh een compatibele Nvidia GPU heeft.

Lezers die mee willen doen aan de AI-revolutie zullen een krachtige Nvidia grafische kaart(zoals deze bij Amazon) nodig hebben om AI-vaardigheden en -apps te ontwikkelen.

Top 10 Testrapporten

» Top 10 Multimedia Notebooks

» Top 10 Gaming-Notebooks

» Top 10 Budget Gaming Laptops

» Top 10 Lichtgewicht Gaming-Notebooks

» Top 10 Premium Office/Business-Notebooks

» Top 10 Budget Office/Business-Notebooks

» Top 10 Workstation-Laptops

» Top 10 Subnotebooks

» Top 10 Ultrabooks

» Top 10 Notebooks tot €300

» Top 10 Notebooks tot €500

» Top 10 Notebooks tot € 1.000De beste notebookbeeldschermen zoals getest door Notebookcheck

» De beste notebookbeeldschermen

» Top Windows Alternatieven voor de MacBook Pro 13

» Top Windows Alternatieven voor de MacBook Pro 15

» Top Windows alternatieven voor de MacBook 12 en Air

» Top 10 best verkopende notebooks op Amazon

» Top 10 Convertible Notebooks

» Top 10 Tablets

» Top 10 Tablets tot € 250

» Top 10 Smartphones

» Top 10 Phablets (>90cm²)

» Top 10 Camera Smartphones

» Top 10 Smartphones tot €500

» Top 10 best verkopende smartphones op Amazon

Bron(nen)

NVIDIA lanceert Blackwell-aangedreven DGX SuperPOD voor generatieve AI-supercomputing op triljoen-parameter-schaal

Schaalt op tot tienduizenden Grace Blackwell Superchips met behulp van de meest geavanceerde NVIDIA netwerken, NVIDIA full stack AI-software en opslag, met tot 576 Blackwell GPU's die als één verbonden zijn met NVIDIA NVLink NVIDIA systeemexperts versnellen de implementatie voor onmiddellijke AI-infrastructuur

18 maart 2024

gTC-NVIDIA heeft vandaag haar volgende generatie AI-supercomputer aangekondigd - de NVIDIA DGX SuperPOD™, aangedreven door NVIDIA GB200 Grace Blackwell Superchips - voor het verwerken van triljoen-parameter-modellen met constante uptime voor superscale generatieve AI-training en inferentie workloads.

De nieuwe DGX SuperPOD, met een nieuwe, zeer efficiënte, vloeistofgekoelde rack-scale architectuur, is gebouwd met NVIDIA DGX™ GB200 systemen en biedt 11,5 exaflops aan AI-supercomputing bij FP4-precisie en 240 terabytes aan snel geheugen - schaalbaar naar meer met extra racks.

Elk DGX GB200 systeem bevat 36 NVIDIA GB200 Superchips - waaronder 36 NVIDIA Grace CPU's en 72 NVIDIA Blackwell GPU's - die als één supercomputer verbonden zijn via NVIDIA NVLink® van de vijfde generatie. GB200 Superchips leveren tot 30x hogere prestaties in vergelijking met de NVIDIA H100 Tensor Core GPU voor grote inferentiewerklasten van taalmodellen.

"NVIDIA DGX AI supercomputers zijn de fabrieken van de AI industriële revolutie," zegt Jensen Huang, oprichter en CEO van NVIDIA. "De nieuwe DGX SuperPOD combineert de nieuwste ontwikkelingen op het gebied van NVIDIA versnelde computing, netwerken en software om elk bedrijf, elke industrie en elk land in staat te stellen hun eigen AI te verfijnen en te genereren."

De door Grace Blackwell aangedreven DGX SuperPOD bestaat uit acht of meer DGX GB200 systemen en kan worden opgeschaald tot tienduizenden GB200 Superchips die verbonden zijn via NVIDIA Quantum InfiniBand. Voor een enorme gedeelde geheugenruimte om AI-modellen van de volgende generatie van energie te voorzien, kunnen klanten een configuratie implementeren die de 576 Blackwell GPU's in acht DGX GB200 systemen verbindt via NVLink.

Nieuwe DGX SuperPOD-architectuur op rackschaal voor het tijdperk van generatieve AI

De nieuwe DGX SuperPOD met DGX GB200 systemen beschikt over een uniforme compute fabric. Naast NVIDIA NVLink van de vijfde generatie bevat de fabric NVIDIA BlueField®-3 DPU's en zal NVIDIA Quantum-X800 InfiniBand-netwerken ondersteunen, die vandaag apart worden aangekondigd. Deze architectuur biedt tot 1.800 gigabyte per seconde aan bandbreedte voor elke GPU in het platform.

Daarnaast biedt de vierde generatie NVIDIA Scalable Hierarchical Aggregation and Reduction Protocol (SHARP)™ technologie 14,4 teraflops aan In-Network Computing, een 4x hogere next-generation DGX SuperPOD architectuur vergeleken met de vorige generatie.

Kant-en-klare architectuur in combinatie met geavanceerde software voor ongeëvenaarde uptime

De nieuwe DGX SuperPOD is een complete AI-supercomputer op datacenterschaal die wordt geïntegreerd met krachtige opslag van NVIDIA-gecertificeerde partners om te voldoen aan de eisen van generatieve AI-workloads. Elke SuperPOD wordt in de fabriek gebouwd, bekabeld en getest om de implementatie in datacenters van klanten drastisch te versnellen.

De door Grace Blackwell aangedreven DGX SuperPOD beschikt over intelligente mogelijkheden voor voorspellend beheer om continu duizenden datapunten in hardware en software te monitoren om bronnen van downtime en inefficiëntie te voorspellen en te onderscheppen - en zo tijd, energie en computerkosten te besparen.

De software kan probleemgebieden identificeren en onderhoud plannen, computermiddelen flexibel aanpassen en taken automatisch opslaan en hervatten om downtime te voorkomen, zelfs zonder dat er systeembeheerders aanwezig zijn.

Als de software detecteert dat er een vervangend onderdeel nodig is, zal het cluster stand-by capaciteit activeren om ervoor te zorgen dat het werk op tijd klaar is. Eventuele vereiste hardwarevervangingen kunnen worden ingepland om ongeplande downtime te voorkomen.

NVIDIA DGX B200 Systems Advance AI Supercomputing for Industries

NVIDIA heeft ook het NVIDIA DGX B200 systeem onthuld, een verenigd AI supercomputing platform voor AI modeltraining, fine-tuning en inferentie.

DGX B200 is de zesde generatie luchtgekoelde, traditionele DGX-ontwerpen voor rekmontage die wereldwijd door industrieën worden gebruikt. Het nieuwe Blackwell architectuur DGX B200 systeem bevat acht NVIDIA Blackwell GPU's en twee 5e generatie Intel® Xeon® processoren. Klanten kunnen ook DGX SuperPOD systemen bouwen met DGX B200 systemen om AI Centers of Excellence te creëren die het werk van grote teams van ontwikkelaars die veel verschillende jobs uitvoeren van energie kunnen voorzien.

DGX B200-systemen bevatten de FP4-precisiefunctie in de nieuwe Blackwell-architectuur, die tot 144 petaflops aan AI-prestaties, een enorm 1,4 TB GPU-geheugen en 64 TB/s aan geheugenbandbreedte biedt. Dit levert 15x snellere real-time inferentie voor biljoen-parameter-modellen dan de vorige generatie.

DGX B200 systemen bevatten geavanceerde netwerken met acht NVIDIA ConnectX™-7 NIC's en twee BlueField-3 DPU's. Deze bieden tot 400 gigabit per seconde bandbreedte per verbinding - en leveren snelle AI-prestaties met NVIDIA Quantum-2 InfiniBand en NVIDIA Spectrum™-X Ethernet-netwerkplatforms.

Software en ondersteuning door experts om productie-AI te schalen

Alle NVIDIA DGX-platforms bevatten NVIDIA AI Enterprise-software voor ontwikkeling en implementatie op bedrijfsniveau. DGX-klanten kunnen hun werk versnellen met de voorgetrainde NVIDIA foundation modellen, frameworks, toolkits en nieuwe NVIDIA NIM microservices die in het softwareplatform zijn opgenomen.

NVIDIA DGX-experts en geselecteerde NVIDIA-partners die gecertificeerd zijn om DGX-platforms te ondersteunen, helpen klanten bij elke stap van de implementatie, zodat ze AI snel in productie kunnen nemen. Zodra systemen operationeel zijn, blijven DGX-experts klanten ondersteunen bij het optimaliseren van hun AI-pijplijnen en -infrastructuur.

Beschikbaarheid

NVIDIA DGX SuperPOD met DGX GB200 en DGX B200 systemen zullen naar verwachting later dit jaar verkrijgbaar zijn bij NVIDIA's wereldwijde partners.

Bekijk voor meer informatie een herhaling van de GTC keynote of bezoek de NVIDIA stand op de GTC, die tot en met 21 maart wordt gehouden in het San Jose Convention Center.