De magie van Dall-E of Stabiele Verspreiding zou nu wel bekend moeten zijn. Uit een korte beschrijving van de scène, de inhoud en misschien één of twee opmerkingen ontstaat een min of meer realistisch beeld. Gelukkig is dit meestal te herkennen als een door AI gegenereerd werk, maar het dient ook zijn doel: ik hoef geen hond op een surfplank te zetten of een vos in een astronautenpak. De gewenste afbeelding is slechts een paar klikken verwijderd.

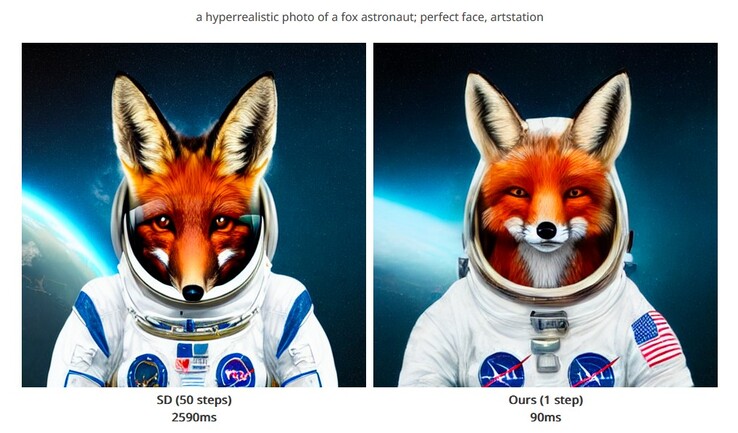

Op de achtergrond is het echter een rekenintensief proces dat bestaat uit talloze iteraties, constante herhalingen van het algoritme om uiteindelijk bij de gewenste afbeelding uit te komen. Onderzoekers van het MIT zijn er echter in geslaagd om deze talrijke tussenstappen achterwege te laten. In plaats daarvan wordt de beschreven scène na precies één stap gecreëerd.

Hierdoor is het mogelijk om een vergelijkbaar resultaat te bereiken terwijl de benodigde rekenkracht of wachttijden aanzienlijk worden verminderd. Tegelijkertijd is er minder stroom nodig om het systeem genaamd "Distribution Matching Distillation (DMD)" aan te drijven.

Om het figuurlijker uit te drukken: de beelden die voor training worden gebruikt, worden opgesplitst in grovere gebieden. Dit bepaalt de beeldcompositie bij benadering, afhankelijk van het onderwerp. Bovendien wordt de waarschijnlijkheid van verschillende beeldelementen geanalyseerd om uiteindelijk een coherente scène te verkrijgen.

Uiteindelijk wordt de gedetailleerde informatie en de complexiteit gereduceerd, zodat de beeldgenerator gewoon sneller wordt. In plaats van 2 tot 3 seconden per afbeelding, neemt dezelfde hardware ongeveer 100 milliseconden - een dertigste - in beslag.

Als u de afbeeldingen goed bekijkt, is de vermindering in detail duidelijk zichtbaar. Achtergronden zijn enigszins wazig en beeldelementen kunnen herhaald worden. De motieven zien er in sommige gevallen nog steeds aanzienlijk beter uit en zijn nog steeds gemakkelijker te herkennen als een algemeen werk van kunstmatige intelligentie, of in ieder geval kunstmatig. Nog een positief effect.

Naast de vossenastronaut kunt u hier nog veel meer voorbeelden van het DMD-model vinden.

Top 10 Testrapporten

» Top 10 Multimedia Notebooks

» Top 10 Gaming-Notebooks

» Top 10 Budget Gaming Laptops

» Top 10 Lichtgewicht Gaming-Notebooks

» Top 10 Premium Office/Business-Notebooks

» Top 10 Budget Office/Business-Notebooks

» Top 10 Workstation-Laptops

» Top 10 Subnotebooks

» Top 10 Ultrabooks

» Top 10 Notebooks tot €300

» Top 10 Notebooks tot €500

» Top 10 Notebooks tot € 1.000De beste notebookbeeldschermen zoals getest door Notebookcheck

» De beste notebookbeeldschermen

» Top Windows Alternatieven voor de MacBook Pro 13

» Top Windows Alternatieven voor de MacBook Pro 15

» Top Windows alternatieven voor de MacBook 12 en Air

» Top 10 best verkopende notebooks op Amazon

» Top 10 Convertible Notebooks

» Top 10 Tablets

» Top 10 Tablets tot € 250

» Top 10 Smartphones

» Top 10 Phablets (>90cm²)

» Top 10 Camera Smartphones

» Top 10 Smartphones tot €500

» Top 10 best verkopende smartphones op Amazon