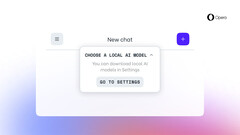

Opera One gebruikers in de developer stream krijgen een grote upgrade. Met de nieuwste update kunnen gebruikers LLM's lokaal downloaden en gebruiken. Op dit moment zijn er modellen uit meer dan 50 families, en er zijn meer dan 150 verschillende modellen die gebruikers kunnen downloaden en op hun computer kunnen uitvoeren.

Enkele van de opmerkelijke modellen zijn Gemma van Google, LLaMA van Meta, Mixtral van Mistral AIen Vicuna van LMSYS. Deze nieuwe functie wordt uitgerold als onderdeel van het AI Feature Drops Program. Dat wil zeggen dat gebruikers die de ontwikkelaarsversie van Opera One om de update te testen.

Desondanks is Opera hiermee de eerste webbrowser die gebruikers toestaat om lokale LLM's te downloaden en te gebruiken. Voor degenen die het zich afvragen: het lokaal uitvoeren van deze modellen biedt vaak volledige controle, minder latentie en, het belangrijkste, betere privacy. Maar uw computer moet wel aan een aantal eisen voldoen.

Het webbrowserbedrijf zegt bijvoorbeeld dat elke variant van de lokale LLM meer dan 2 GB opslagruimte nodig heeft. Wat betreft het uitvoeren van de modellen, zegt Opera dat het gebruik maakt van het open-source framework Ollama. Dat betekent ook dat alle modellen die momenteel beschikbaar zijn in de browser een subset zijn van de Ollama-bibliotheek. Het mooie is dat Opera van plan is om ook modellen van andere bronnen toe te voegen.

Niet alle gebruikers zullen van deze update profiteren. Het is echter goed nieuws voor degenen die verschillende LLM's lokaal op hun machines willen testen. U kunt de ingebouwde AI-assistent genaamd Aria gebruiken als u geen modellen wilt downloaden. Deze is sinds mei vorig jaar beschikbaar voor de gewone versie van de browser.

Bron(nen)

Top 10 Testrapporten

» Top 10 Multimedia Notebooks

» Top 10 Gaming-Notebooks

» Top 10 Budget Gaming Laptops

» Top 10 Lichtgewicht Gaming-Notebooks

» Top 10 Premium Office/Business-Notebooks

» Top 10 Budget Office/Business-Notebooks

» Top 10 Workstation-Laptops

» Top 10 Subnotebooks

» Top 10 Ultrabooks

» Top 10 Notebooks tot €300

» Top 10 Notebooks tot €500

» Top 10 Notebooks tot € 1.000De beste notebookbeeldschermen zoals getest door Notebookcheck

» De beste notebookbeeldschermen

» Top Windows Alternatieven voor de MacBook Pro 13

» Top Windows Alternatieven voor de MacBook Pro 15

» Top Windows alternatieven voor de MacBook 12 en Air

» Top 10 best verkopende notebooks op Amazon

» Top 10 Convertible Notebooks

» Top 10 Tablets

» Top 10 Tablets tot € 250

» Top 10 Smartphones

» Top 10 Phablets (>90cm²)

» Top 10 Camera Smartphones

» Top 10 Smartphones tot €500

» Top 10 best verkopende smartphones op Amazon