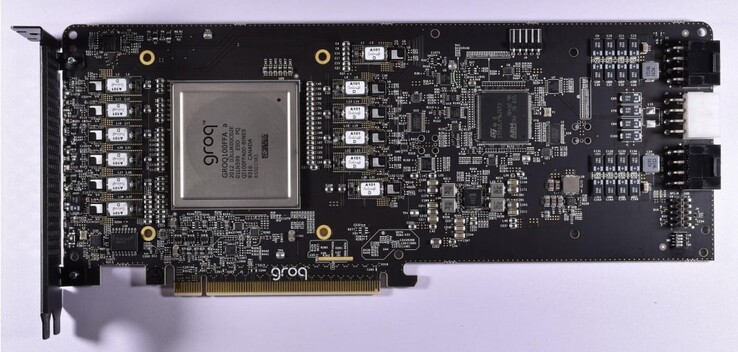

Terwijl Nvidia momenteel uitstekende winsten op de AI-golf met de toenemende vraag naar reken-GPU's, zou de markt meer gedecentraliseerd kunnen worden naarmate meer bedrijven stappen zetten om levensvatbare alternatieve AI-processors te leveren. We hebben inspanningen gezien van verschillende bedrijven in dit opzicht, waaronder AMD, d-Matrix, OpenAI en Samsung. Het lijkt erop dat heel wat ingenieurs die hebben geholpen bij het ontwerpen van Google's tensor processing unit (TPU) nu betrokken zijn bij onafhankelijke AI-projecten die de oplossingen van Nvidia dreigen te overtreffen. Samsung heeft bijvoorbeeld onlangs aangekondigd dat zijn nieuwe AGI Computing Lab in Silicon Valley wordt geleid door de voormalige TPU-ontwikkelaar van Google, Dr. Woo Dong-hyuk. Een andere belangrijke ingenieur die hielp bij de ontwikkeling van de Google TPU is Jonathan Ross, die nu CEO is van een nieuw bedrijf genaamd Groq. Door gebruik te maken van de ervaring die hij bij Google heeft opgedaan, brengt Ross innovatie op de markt voor AI-accelerators met 's werelds eerste Language Processing Unit (LPU).

De LPU van Groq is speciaal ontworpen om grote taalmodellen (LLMs) en heeft duidelijke voordelen ten opzichte van GPU's voor algemene doeleinden of NPUs. Groq ontwikkelde aanvankelijk de Tensor Stream Processor (TSP), die later werd omgedoopt tot Language Processing Unit om de grotere vaardigheid in generatieve AI-taken op basis van inferentie weer te geven. Aangezien de LPU zich alleen richt op LLM's, is deze veel gestroomlijnder dan een GPGPU en maakt deze vereenvoudigde scheduling hardware mogelijk met lagere latentie, aanhoudende doorvoer en verhoogde efficiëntie.

Bijgevolg vermindert de LPU de tijd per berekend woord en kunnen tekstreeksen veel sneller worden gegenereerd. Een andere belangrijke verbetering is dat de LPU het dure geheugen (HBM), aangezien het slechts 230 MB SRAM per chip gebruikt met 80 TB/s bandbreedte, waardoor het aanzienlijk sneller is dan traditionele GPGPU-oplossingen. De architectuur van Groq ondersteunt ook schaalbaarheid, omdat meerdere LPU's onderling kunnen worden verbonden om meer verwerkingskracht te bieden voor complexere LLM's.

Om aan te tonen hoeveel sneller de LPU Inference Engine is in vergelijking met GPU's, biedt Groq een videovergelijking van zijn eigen chatbot die kan schakelen tussen de Llama 2 / Mixtral LLM's versus OpenAI's Chat-GPT. Groq beweert dat de LLM de tekst in een fractie van een seconde genereert en dat de overige 3 ⁄ 4 van de tijd wordt besteed aan het zoeken naar relevante informatie.

Top 10 Testrapporten

» Top 10 Multimedia Notebooks

» Top 10 Gaming-Notebooks

» Top 10 Budget Gaming Laptops

» Top 10 Lichtgewicht Gaming-Notebooks

» Top 10 Premium Office/Business-Notebooks

» Top 10 Budget Office/Business-Notebooks

» Top 10 Workstation-Laptops

» Top 10 Subnotebooks

» Top 10 Ultrabooks

» Top 10 Notebooks tot €300

» Top 10 Notebooks tot €500

» Top 10 Notebooks tot € 1.000De beste notebookbeeldschermen zoals getest door Notebookcheck

» De beste notebookbeeldschermen

» Top Windows Alternatieven voor de MacBook Pro 13

» Top Windows Alternatieven voor de MacBook Pro 15

» Top Windows alternatieven voor de MacBook 12 en Air

» Top 10 best verkopende notebooks op Amazon

» Top 10 Convertible Notebooks

» Top 10 Tablets

» Top 10 Tablets tot € 250

» Top 10 Smartphones

» Top 10 Phablets (>90cm²)

» Top 10 Camera Smartphones

» Top 10 Smartphones tot €500

» Top 10 best verkopende smartphones op Amazon

![Lenovo lanceert de 2024 GeekPro gaming desktop (Beeldbron: Lenovo [Bewerkt])](fileadmin/_processed_/b/f/csm_2024-Lenovo-GeekPro_ba34df66de.jpg)